“Due miliardi di anni fa, i nostri antenati erano microbi; mezzo miliardo di anni fa, pesci; cento milioni di anni fa, qualcosa di simile a topi; dieci milioni di anni fa, scimmie arboricole; un milione di anni fa, protoumani che si chiedevano come addomesticare il fuoco. La nostra linea evolutiva è contrassegnata dalla capacità di dominare il cambiamento. Nella nostra epoca, il ritmo si sta facendo più rapido.” (Carl Sagan)

Le parole sopra citate sono di Carl Sagan, un astronomo, divulgatore scientifico e autore di fantascienza statunitense. Scomparso prematuramente nel 1996, l’astronomo sarebbe stato sicuramente colpito dal carattere profetico delle sue stesse parole se ne avesse visto la completa realizzazione che è oggi sotto i nostri occhi. Gli ultimi vent’anni sono infatti stati caratterizzati da una vera e propria impennata dei progressi tecnologici nel campo della genetica, della nanotecnologia e della robotica.

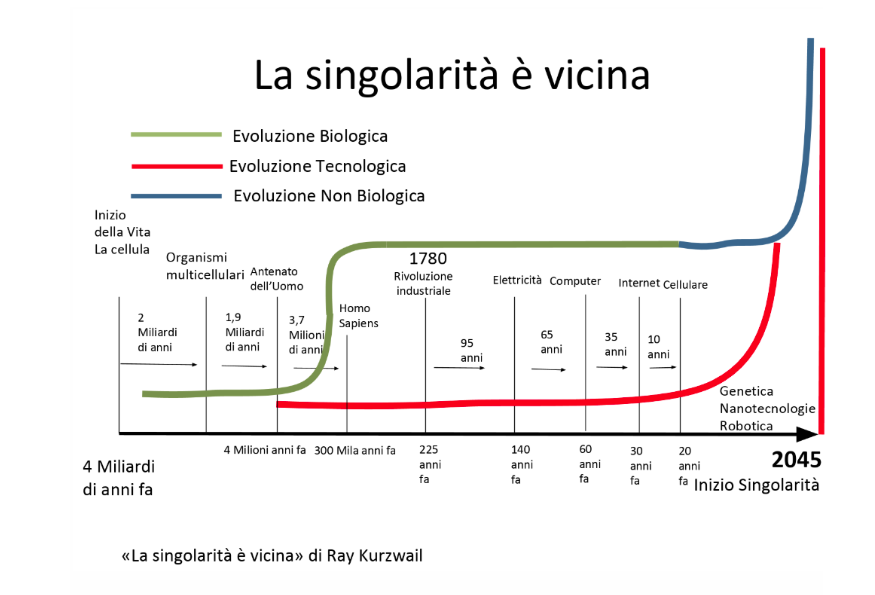

Le parole di Sagan sono riportate in apertura del secondo capitolo del libro La singolarità è vicina, di Ray Kurzweil (lo trovi qui) L’inventore e informatico statunitense sostiene, nel suo saggio, che siamo molto vicini ad un punto in cui la tecnologia si svilupperà in un processo esponenziale dalle conseguenze difficilmente prevedibili.

Si va dunque verso l’evoluzione dell’uomo ad un nuovo livello che oggi non possiamo ancora immaginare?

Per evitare inutili allarmismi abbiamo chiesto il parere di un esperto, Luigi Scopelliti, dottore in Fisica intervenuto allo Speech Cocktail di Sistema Critico incentrato sulla tematica dell’Intelligenza Artificiale.

Se l’intelligenza può essere definita come la capacità di apprendere con l’esperienza, attribuendo un significato a ciò che ci circonda e pianificando di conseguenza le azioni da intraprendere, sarà simile la definizione di intelligenza artificiale. Con questa espressione ci riferiamo infatti a macchine in grado di automatizzare azioni che associamo al pensiero umano: prendere decisioni, risolvere problemi e imparare.

Ciò che una macchina deve saper fare per poter essere considerata un’Intelligenza Artificiale è:

La vera rivoluzione alla base dell’intelligenza artificiale, dunque, non è nella natura dei programmi avanzati che vengono caricati su una macchina e la rendono intelligente. Ciò che differenzia le moderne tecnologie è la capacità delle macchine di imparare attraverso la lettura di file. Le moderne intelligenze artificiali estrapolano informazioni dall’osservazione dei dati e in molti casi trovano addirittura soluzioni innovative rispetto agli esperti che hanno caricato i file. È il caso di DeepMind, l’intelligenza artificiale targata Google, che dopo soli 240 minuti di osservazione delle dinamiche di gioco del videogame Atari Breakout ha appreso la migliore tattica possibile per vincere, rendendosi di fatto imbattibile.

Come si insegna ad una macchina? Dopo aver studiato la struttura del cervello umano, gli esperti di robotica hanno ricavato un modello progettato in modo che la macchina imiti le reti cerebrali (reti neurali) e crei vere e proprie associazioni mentali.

Chi decide cosa è giusto quando si crea un programma che dovrà prendere decisioni a carattere etico? Ad esempio, nei programmi di intelligenza artificiale che sono alla base delle macchine a guida autonoma, in caso di collisione quali sono i principi che spingono il robot a scegliere tra il salvare la vita del guidatore o salvare la vita della persona che sta per essere investita? Una questione spinosa e dalla difficile soluzione.

Il dottor Scopelliti fa una considerazione: per il paradosso del re Mida si può programmare una macchina perché compia la migliore scelta possibile, ma si rischia comunque di creare danni irreparabili. Se diamo un compito ad una macchina, infatti, questa lo eseguirà in ogni caso, anche se ne risultassero danneggiati alcuni dei soggetti coinvolti.

Per essere certi che le macchine non danneggino l’uomo nel prendere decisioni autonome, al momento l’unica strada percorribile sarebbe quella di caricare nel programma tutta la gamma di casi possibili con le relative azioni da intraprendere. Questo, però, minerebbe alla base l’idea di intelligenza, perché la macchina non si dimostrerebbe in grado di decidere in base ad un sistema di valori.

Si potrebbe quindi pensare di insegnare alla macchina i valori in base ai quali prendere decisioni eticamente accettabili. Questo sarà possibile solo dopo aver riscontrato, con un ragionevole grado di certezza, la presenza nelle macchine di una coscienza. Insieme alla coscienza si dovrà poi misurare la capacità della macchina di farne un buon uso. Si parla quindi di evoluzioni future e ancora difficilmente prevedibili.

L’organizzazione di ricerca e sensibilizzazione di Boston, attenta al rischio esistenziale nascosto nelle pieghe degli sviluppi dell’Intelligenza Artificiale, propone un sistema di valori etici da insegnare alle macchine (le modalità, come suggerisce il dottor Scopelliti, sono ancora in fase di definizione):

Indagini di mercato, Ricerche sociali, Insight per le decisioni

Via del cinema, 5 - 61122 Pesaro

+39 0721 415210

info@sigmaconsulting.biz

Sigma Consulting srls unipersonale – P. Iva 02625560418 - Capitale sociale € 2.000,00 i.v. - REA PS 196812 - Privacy Policy - Cookie Policy -

INFORMATIVA SUL TRATTAMENTO DEI DATI PERSONALI

Ai sensi degli articoli 13 e 14 del Regolamento 679/2016/UE e della normativa italiana applicabile in materia di trattamento dei dati personali, La informo che i dati personali da Lei forniti nel corso di questa intervista telefonica, condotta da parte di Sigma Consulting S.r.l.s. o di soggetti dalla stessa incaricati, formeranno oggetto di trattamento nel rispetto della normativa richiamata e degli obblighi di riservatezza a cui è ispirata l’attività di Sigma Consulting S.r.l.s.

In particolare:

ORIGINE DEI DATI

Il Suo nominativo e il Suo recapito telefonico sono stati selezionati da banche dati di società terze. Il trattamento si riferisce ai seguenti dati: nome, cognome, indirizzo e numero di telefono.

Tali dati possono essere forniti al momento del primo contatto telefonico, ovvero al momento della sottoposizione al sondaggio di opinione e/o alla ricerca di mercato, in ogni caso previa prestazione del Suo consenso.

FINALITÁ E MODALITA’ DEL TRATTAMENTO

I dati da Lei forniti o altrimenti acquisiti da Sigma Consulting S.r.l.s. saranno trattati per le finalità di seguito elencate: effettuazione di sondaggi di opinione e effettuazione di ricerche di mercato.

Il trattamento dei Suoi dati avverrà, in ogni caso, mediante modalità, procedure e strumenti cartacei ed elettronici idonei a garantirne la sicurezza, pertinenza, integrità, disponibilità, completezza, non eccedenza e riservatezza.

NATURA DEL CONFERIMENTO DEI DATI

Il conferimento, da parte Sua, del consenso al trattamento dei dati per le finalità anzidette è facoltativo. In caso di rifiuto a fornire i Suoi dati o in mancanza di consenso al loro trattamento Sigma Consulting S.r.l.s. non potrà utilizzare i dati personali e, dunque, non potrà svolgere il sondaggio e/o la ricerca di mercato.

TITOLARE DEL TRATTAMENTO E SOGGETTI AI QUALI I DATI POSSONO ESSERE COMUNICATI O CHE POSSONO VENIRNE A CONOSCENZA, E AMBITO DI DIFFUSIONE DEI DATI

Il titolare del trattamento è Sigma Consulting S.r.l.s. (P.IVA 02625560418), con sede legale in Pesaro, Via del Cinema n. 5, CAP 61122, email: sigmaconsulting@gigapec.it

D.P.O. Email: privacy@sigmaconsulting.biz Pec: privacysigmaconsulting@gigapec.it

I Suoi dati personali saranno trattati da dipendenti, collaboratori, consulenti e professionisti incaricati da Sigma Consulting S.r.l.s. di svolgere specifiche attività in relazione alle suddette finalità di trattamento o per adempiere ad un obbligo di legge. I dati personali da Lei forniti a Sigma Consulting S.r.l.s. potranno essere in alcuni casi e temporaneamente trasferiti in un paese Extra UE nel rispetto delle disposizioni di cui agli artt. 44 e ss. del Regolamento (UE) 679/2016.

DURATA DEL TRATTAMENTO

I Suoi dati saranno trattati per tutto il periodo di svolgimento del sondaggio o della ricerca di mercato. Al termine del sondaggio o della ricerca di mercato, i Suoi dati verranno anonimizzati o trattati esclusivamente in forma aggregata, in modo tale che li stessi non siano identificabili e che non si possa risalire alle Sue risposte .

DIRITTI DELL’INTERESSATO

Relativamente ai Suoi dati personali, Lei potrà in ogni momento, mediante semplice richiesta scritta indirizzata al Titolare e/o D.P.O., anche a mezzo email o tramite soggetto delegato (i) ottenere l'accesso ai dati personali per conoscere origine dei dati, finalità del trattamento, logica applicata al trattamento con uso di strumenti elettronici, categorie di dati, destinatari (o categorie di destinatari) ai quali gli stessi saranno comunicati, periodo di conservazione, e la loro comunicazione in una forma intellegibile; (ii) ottenere la rettifica, l’integrazione, la cancellazione dei dati o la limitazione del trattamento; (iii) opporsi al trattamento dei dati personali; (iv) ottenere la portabilità dei dati, ove pertinente; (v) revocare il consenso in qualsiasi momento; (vi) proporre reclamo ad un'autorità di controllo.

Per l’esercizio di tali diritti potrà contattare, telefonicamente e/o per iscritto, Sigma Consulting S.r.l.s. ai seguenti recapiti: Sigma Consulting S.r.l.s., sede legale Pesaro (PU), Via del Cinema n. 5, c.a.p. 61122; Tel.: 0721.415210 Fax: 0721.1622038 E-mail: community@sigmaconsulting.biz P.E.C.: sigmaconsulting@gigapec.it

D.P.O. Email: privacy@sigmaconsulting.biz Pec: privacysigmaconsulting@gigapec.it